Google открыл AI-модель Gemma, основанную на технологиях, общих с чат-ботом Gemini

Компания Google объявила о публикации большой языковой модели машинного обучения Gemma, построенной с использованием технологий, применяемых для построения модели чат-бота Gemini, пытающегося конкурировать с ChatGPT. Модель доступна в четырёх вариантах, охватывающих 2 и 7 миллиардов параметров, в базовом и оптимизированном для диалоговых систем представлениях. Варианты с 2 млрд параметров подходят для использования в потребительских приложениях и для его обработки достаточно CPU. Варианты с 7 млрд параметров требуют более мощного оборудования и наличия GPU или TPU.

Среди областей применения модели Gemma называется создание диалоговых систем и виртуальных ассистентов, генерация текста, формирование ответов на вопросы, заданные на естественном языке, краткое изложение и обобщение содержимого, объяснение сути концепций и терминов, исправление ошибок в тексте, помощь в изучении языков. Поддерживается создание различных видов текстовых данных, включая стихи, код на языках программирования, рерайтинг произведений другими словами, формирование писем по шаблону. При этом модель имеет относительно небольшой размер, позволяющий использовать её на своём оборудовании с ограниченными ресурсами, например, на обычных ноутбуках и ПК.

Лицензия на модель разрешает бесплатное использование и распространение не только в исследовательских и персональных проектах, но и в коммерческих продуктах. Также разрешено создание и публикация изменённых вариантов модели. При этом условия использования запрещают применение модели для совершения вредоносных действий и предписывают по возможности использовать в своих продуктах самую свежую версию Gemma.

Поддержка работы с моделями Gemma уже добавлена в инструментарий Transformers и в Responsible Generative AI Toolkit. Для оптимизации модели можно использовать фреймворк Keras и бэкенды для TensorFlow, JAX и PyTorch. Также обеспечена возможность использования Gemma с фреймворками MaxText, NVIDIA NeMo и TensorRT-LLM.

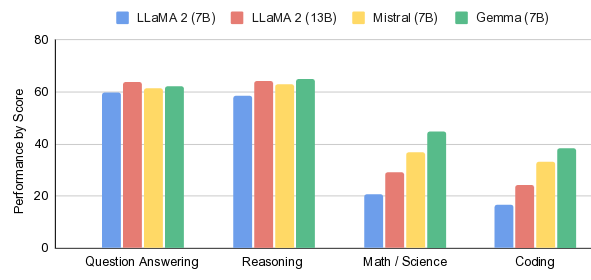

Размер учитываемого моделью Gemma контекста составляет 8 тысяч токенов (число токенов, которые модель может обработать и запомнить при генерации текста). Для сравнения размер контекста у моделей Gemini и GPT-4 составляет 32 тысячи токенов, а у модели GPT-4 Turbo — 128 тысяч. Моделью поддерживается только английский язык. По производительности модель Gemma-7B немного уступает модели LLama 2 70B Chat и немного опережает модели DeciLM-7B, PHI-2 (2.7B) и Mistral-7B-v0.1. В сравнении Google модель Gemma-7B немного опережает LLama 2 7B/13B и Mistral-7B.

Источник: http://www.opennet.ru/opennews/art.shtml? num=60642

© OpenNet