Как сделать pruning, чтобы потом не плакать

Обрезка нейросетей или же, если вникать в термины, pruning — то, что помогает уменьшить размер нашей модели без потери ее эффективности. Да, это далеко не новинка — в стэнфордских лекциях еще в 2017 году об этом говорили!

Идея проста: мы просто убираем из модели все, что нам не нужно. Как в магазине, когда решил экономить: если в корзине лежат лишние товары, то почему бы их не убрать? Так и здесь — мы убираем избыточные нейроны и связи, которые только занимают место, но не приносят особой пользы.

Принцип обрезки можно применять в разных ситуациях. Например, если у нас есть модель, которая обучена для распознавания ста классов объектов, а нам на самом деле нужно только десять, то почему бы не убрать те девяносто лишних? Это позволит нам сделать модель поменьше, но не менее эффективной. А если мы создаем модель с нуля, то обрезка может помочь нам сразу сделать ее компактнее и эффективнее.

Короче, pruning — это для тех, кто хочет сделать свои модели легче и быстрее без потери качества.

Зачем вообще резать нейросети?

Чтобы это понять, можно представить, что нейросеть — это ракета. Каждый элемент в этой ракете имеет свою важную роль: от двигателей до систем навигации. И, как и в любой сложной системе, нейронные сети могут стать избыточными, содержащими лишние элементы, которые могут замедлить их работу или даже привести к нежелательным последствиям.

Pruning как раз и подобен оптимизации ракеты перед запуском. Мы ищем и удаляем «лишние» связи между нейронами, которые несут мало или никакой ценной информации. Это позволяет сделать нейросети более лёгкими и эффективными.

Вот почему pruning так важен. Он позволяет нам создавать более эффективные нейросети, которые могут лучше выполнять свои задачи. Это особенно актуально в случае работы с ограниченными ресурсами, например, на мобильных устройствах или в облачных вычислениях.

Применение pruning также помогает сделать нейронные сети более устойчивыми к переобучению. Убирая избыточные связи, мы создаем более простые и эффективные модели, которые лучше обобщают информацию из тренировочных данных.

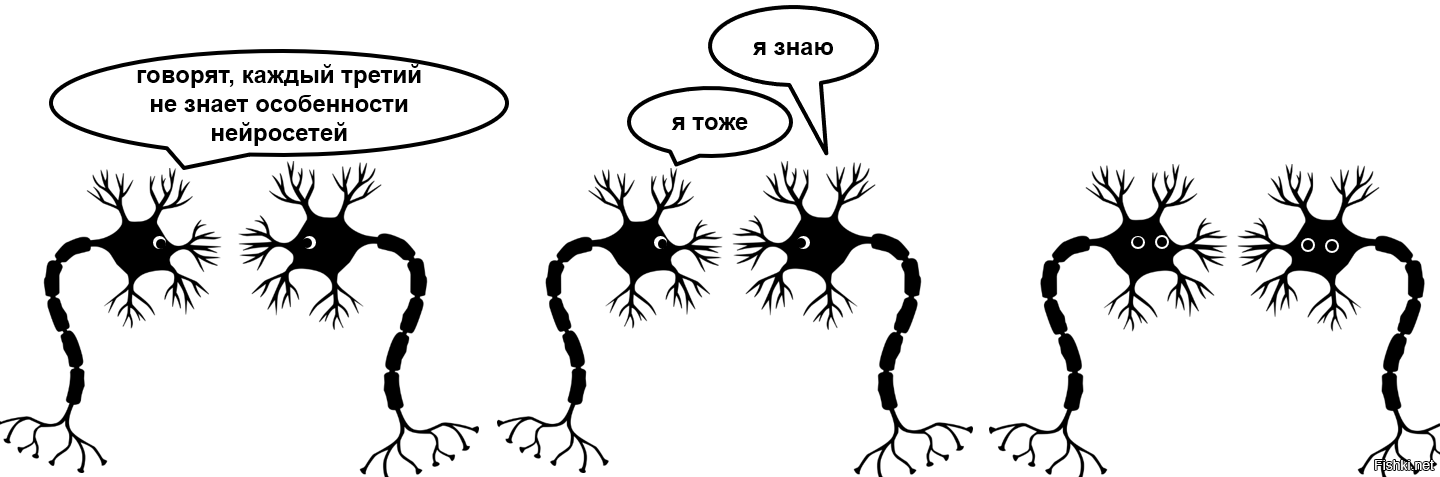

Чтобы было ещё понятнее, можем взглянуть на pruning с точки зрения биологии, используя аналогию с реальным человеческим мозгом. Процесс Model Pruning, как и механизмы пластичности мозга, связаны со способностью системы адаптироваться и изменяться в ответ на изменяющиеся условия.

Пластичность мозга — это его способность изменять свою структуру и функции в результате опыта и обучения. Подобно тому, как мозг может реорганизовывать свои нейронные связи для адаптации к новым условиям, нейронные связи в нейросети могут быть удалены или изменены для оптимизации ее работы.

Это можно сравнить с тем, как мозг реорганизует свою структуру, чтобы лучше адаптироваться к новым условиям. Гибкость — вот что главное. И pruning позволяет создавать более гибкие нейросети, способные решать задачи на максимум при минимальном использовании ресурсов.

Какими инструментами пользоваться и что обрезать

Возможно ли понять, как каждый вес влияет на работу всей нейросети? Безусловно. Для этого мы используем инструменты анализа весов.

Вот как это работает: представьте, что каждый вес в нашей нейросети это как брусок в той настолке, дженге. В этой игре нужно понять, какой брусок важен для деревянной башни, а какой можно осторожно убрать, не повредив всей конструкции. Так и здесь: мы анализируем влияние каждого веса на работу всей сети.

Один из инструментов, который мы используем для этого, называется анализ значимости весов. Мы смотрим и анализируем, какой вес как-то влияет на выход сети. Если какой-то вес вносит очень маленький вклад в итоговый результат, мы можем думать о том, чтобы его выкинуть из нашей модели.

Для того чтобы это понять, мы обычно обращаемся к методам, основанным на градиентах. Нужно понять, какие веса оказывают наименьшее влияние на изменение нашей функции ошибки. Или потерь, как вам удобнее.

Функция потерь — это мера, которая показывает, насколько хорошо модель выполняет задачу. Она измеряет разницу между предсказанными значениями модели и фактическими данными. Чем меньше функция потерь, тем лучше модель работает. Именно она определяет, какие параметры модели нужно изменить, чтобы уменьшить ошибку и улучшить ее производительность.

Для обучения нейросетей мы обычно используем какую-то функцию потерь, которая оценивает, насколько близки предсказания модели к истинным значениям. Например, в задачах классификации часто используется кросс-энтропия, а в задачах регрессии —- среднеквадратичная ошибка MSE.

Кросс-энтропия (Cross-Entropy) измеряет различие между двумя вероятностными распределениями и используется для оценки качества модели классификации.

Чем меньше кросс-энтропия, тем лучше модель.

Пример на Python:

import numpy as np

def cross_entropy(y_true, y_pred):

# Ограничиваем значения y_pred, чтобы избежать логарифма от нуля

epsilon = 1e-15

y_pred = np.clip(y_pred, epsilon, 1 - epsilon)

# Вычисляем кросс-энтропию

ce = -np.sum(y_true * np.log(y_pred))

return ce

# Пример данных

# Реальные метки (one-hot encoding)

y_true = np.array([0, 0, 1, 0, 0])

# Предсказанные вероятности классов моделью

y_pred = np.array([0.1, 0.2, 0.6, 0.05, 0.05])

# Вычисляем кросс-энтропию

ce = cross_entropy(y_true, y_pred)

print("Cross-Entropy:", ce)В этом примере мы используем numpy для вычисления кросс-энтропии между реальными метками и предсказанными вероятностями модели.

Среднеквадратичная ошибка (MSE — Mean Squared Error) измеряет среднеквадратичное отклонение (квадрат разности) между предсказанными значениями модели и реальными значениями данных.

Чем меньше значение MSE, тем лучше модель.

Пример на Python:

import numpy as np

def mean_squared_error(y_true, y_pred):

# Вычисляем квадрат разности между реальными и предсказанными значениями

squared_diff = (y_true - y_pred) ** 2

# Вычисляем среднее значение квадратов разностей

mse = np.mean(squared_diff)

return mse

# Пример данных

y_true = np.array([3, -0.5, 2, 7])

y_pred = np.array([2.5, 0.0, 2, 8])

# Вычисляем среднеквадратичную ошибку

mse = mean_squared_error(y_true, y_pred)

print("Mean Squared Error (MSE):", mse)Здесь мы используем numpy для вычисления среднеквадратичной ошибки между реальными значениями и предсказанными значениями модели.

Таким образом, если какой-то вес не сильно меняет функцию потерь, значит, его можно спокойно убирать.

Ещё TensorFlow или PyTorch делают жизнь проще, когда речь идет о прунинге нейросетей. Они уже содержат в себе все нужные инструменты и функции, чтобы провести эту процедуру. Просто вызываешь нужные методы, и вуаля! Вообще в TF и PT есть много инструментов для анализа моделей, что помогает понять, какие части сети можно убрать и не переживать о том, что выкинул что-то важное. В итоге прунинг становится делом пары кликов и немного мозгового штурма, вместо долгих часов настройки модели вручную.

В каких ситуациях pruning будет бесполезен, а в каких — нужен прям на максималках

А сейчас посмотрим, когда прунинг будет, как говорится, «не в тему», а когда просто необходим.

Допустим, вы имеете дело с маленькой моделью, где количество параметров и так не особо большое. В таких случаях прунинг может просто не приносить заметного улучшения, а вот затраты на его проведение могут быть неоправданно высокими. Это как пытаться похудеть человеку, который и так в отличной форме. Просчитался, но где?

Другой случай — масштабы. Если ваша модель — это монстр с миллионами параметров, которые занимают кучу места и времени на обучение, то прунинг здесь как раз будет кстати. Убираете те нейроны, которые оказывают мало влияния на результаты, и модель становится компактнее и быстрее, но при этом сохраняет свою эффективность.

Можно сказать, что прунинг — это как очистка мозга от информационного мусора, который мешает ему работать эффективно. Когда мы удаляем ненужные веса и связи в нейронной сети, мы фактически освобождаем ее от избыточной информации, что помогает сделать ее более легкой и быстрой в работе, а также улучшить ее способность принимать решения.

Для чего это вообще нужно: разбираем на примерах

Мы уже поняли, что прунинг –- это важная штука в ML. Теперь окончательно разберемся, для чего это все вообще нужно, и зачем морочиться с о̶б̶р̶е̶з̶а̶н̶и̶е̶м прунингом нейросетей.

Допустим, у вас есть нейросеть для распознавания изображений. Она умеет различать кошек, собак, автомобили и прочие объекты. Но вот черт: у этой модели слишком много весов и нейронных связей, из-за чего она пашет еле-еле… Вот тут ей и поможет нейрофитнес — прунинг.

Примерно как на диете: когда лишние килограммы мешают двигаться, мы начинаем убирать из своего питания всякую фигню, чтобы похудеть, да и здоровье поправить. В случае с нейросетями, мы убираем избыточные связи и веса, чтобы сеть стала более легкой и быстрой. Да еще и работает она также, если не лучше!

Вот простой пример на Python:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# Создаем простую модель

model = Sequential([

Dense(128, activation='relu', input_shape=(784,)),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

# Компилируем модель

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# Обучаем модель (тут, конечно, используйте свои данные)

model.fit(x_train, y_train, epochs=5)

# Проводим прунинг

pruned_model = prune_low_magnitude(model)

pruned_model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# И снова обучаем

pruned_model.fit(x_train, y_train, epochs=3)Вот так прунинг помогает сделать наши модели легче и быстрее без потери качества!

Как сделать pruning, чтобы потом не плакать

Давайте разберемся, как сделать pruning, чтобы потом не плакать от нежелательных последствий. Во-первых, всегда имейте в виду, что прунинг может привести к потере качества модели. Поэтому перед тем как приступить, тщательно оценивайте, насколько сильно можно уменьшить размер сети без значительных ущербов для ее производительности.

Во-вторых, выбирайте правильные методы и стратегии. Существует несколько подходов к выбору нейронов или весов для удаления (об этом мы говорили выше). Выбор правильного метода зависит от характеристик модели и конкретной задачи.

Третий совет — не удаляйте слишком много сразу. Лучше начать с небольшого количества нейронов или весов и постепенно увеличивать, проверяя при этом качество модели на валидационном наборе данных.

И конечно, всегда тестируйте изменения. После каждого этапа прунинга тщательно оценивайте производительность модели на тестовом наборе данных. Это поможет избежать неприятных сюрпризов в виде потери качества.

Ну и последнее: будьте готовы к тому, что не всегда получается добиться значительного уменьшения размера модели без потери точности. Поэтому имейте в виду, что pruning — это инструмент оптимизации, а не универсальное решение для уменьшения размера моделей.

Врезались в стену: что делать, если все пошло… не так как, планировали

Первая проблема, с которой можно столкнуться, — потеря качества модели после прунинга. Да, это как раз то, о чём мы и предупреждаем на протяжении всей статьи.

Решение есть, но оно мало кому нравится. Нужно внимательно тестировать модели после каждого этапа прунинга. Это позволит выявить ухудшение производительности и, если необходимо, скорректировать процесс удаления весов и связей.

Вторая проблема — сложность выбора оптимальной стратегии прунинга. Да, как уже была речь выше, существует много различных методов и подходов к прунингу, и выбор правильного может быть нетривиальным. Рекомендуется начинать с простых методов и постепенно переходить к более сложным, оценивая при этом влияние каждого метода на производительность модели.

Третья проблема — сложность поддержания обновленных моделей. После прунинга модель может потребовать пересмотра и обновления других компонентов, таких как оптимизаторы и гиперпараметры. Чтобы решить эту проблему, важно разработать стратегию автоматического обновления модели и ее компонентов после прунинга.

И, наконец, четвертая сложность — управление процессом прунинга. Это может быть длительный и ресурсоемкий процесс, особенно при работе с большими моделями и наборами данных. Для решения этой проблемы важно оптимизировать процесс прунинга, например, используя распределенные вычисления или специализированные аппаратные решения.

В целом, важно помнить, что прунинг — это не конечная цель, а инструмент оптимизации моделей. Сложности могут возникнуть. И это нормально. Но с правильным подходом и стратегиями их можно преодолеть и добиться хороших результатов.

Это не конец, это только начало

Кстати о том, что прунинг — это не конечная цель. Есть ещё много работы, которая должна быть сделана после.

А после прунинга приходит время для тюнинга, оптимизации и адаптации модели к новым условиям и задачам. Мы можем исследовать методы дистилляции знаний, которые помогут перенести знания из большой модели в усеченную. А еще можно рассмотреть различные методы компрессии и квантизации, чтобы добиться еще большей эффективности работы моделей на устройствах с ограниченными ресурсами.

В общем, предстоит сделать еще много работы, но это всё то, что помогает нам осознать важность труда. Ведь только так можно развиваться, постоянно совершенствуя старое и создавая новое.